Robots.txt: Crea un Archivo Robots.txt para Controlar el Acceso de los Bots

El archivo robots.txt es una herramienta fundamental para controlar el acceso de los bots de rastreo a tu sitio web. Este archivo, ubicado en la raíz de tu dominio, permite especificar qué secciones de tu sitio web son accesibles para los bots y cuáles no. En este artículo, te explicaremos cómo crear un archivo robots.txt efectivo y optimizarlo para garantizar que los bots accedan a las páginas relevantes y eviten las áreas que desees proteger.

-

Robots.txt: Controla el Acceso de los Bots a Tu Sitio Web

- ¿Qué es un archivo Robots.txt?

- ¿Para qué sirve un archivo Robots.txt?

- Proteger contenido sensible: Puedes evitar que los robots rastreen páginas que contengan información confidencial, como áreas de administración, formularios de registro o datos de usuarios. Mejorar el rendimiento del sitio: Al restringir el acceso a páginas no importantes, reduces la carga en tu servidor y mejoras la velocidad de carga de tu sitio web. Controlar el rastreo de imágenes y archivos multimedia: Puedes especificar qué imágenes y archivos multimedia se pueden indexar y cuáles no. Evitar el rastreo de páginas duplicadas: Puedes evitar que los robots rastreen versiones duplicadas de tu sitio web, como páginas con parámetros de URL diferentes. Gestionar el rastreo de sitios web dinámicos: Puedes controlar cómo los robots rastrean sitios web que utilizan tecnologías como JavaScript o AJAX.

- ¿Cómo se crea un archivo Robots.txt?

- Crea un archivo de texto plano con el nombre robots.txt. Agrega las instrucciones para los robots en el archivo, utilizando el siguiente formato: User-agent: Nombre del robot o del motor de búsqueda. Disallow: URL o ruta a la que no se debe acceder. Allow: URL o ruta a la que sí se debe acceder.

- ¿Ejemplos de Instrucciones en Robots.txt?

- Permitir el rastreo de todo el sitio web: User-agent: Disallow:

- Bloquear el rastreo de una carpeta específica: User-agent: Disallow: /admin/

- Permitir el rastreo de una página específica: User-agent: Allow: /contacto/

- Bloquear el rastreo de todos los archivos PDF: User-agent: Disallow: .pdf

- Bloquear el rastreo de todas las imágenes: User-agent: Disallow: /images/

- ¿Cómo comprobar si tu archivo Robots.txt funciona correctamente?

- ¿Qué es un archivo bot?

- ¿Dónde está el archivo robots.txt en WordPress?

- ¿Qué es el archivo robots.txt personalizado en Blogger?

- Mas informacion

Robots.txt: Controla el Acceso de los Bots a Tu Sitio Web

¿Qué es un archivo Robots.txt?

El archivo Robots.txt es un archivo de texto plano que se coloca en la raíz de tu sitio web (en la misma carpeta que tu archivo index.html) y que contiene instrucciones para los robots de los motores de búsqueda, como Google, Bing y Yahoo. Estas instrucciones les dicen a los robots qué páginas de tu sitio web pueden rastrear y cuáles no.

¿Para qué sirve un archivo Robots.txt?

El archivo Robots.txt tiene varias funciones importantes:

- Proteger contenido sensible: Puedes evitar que los robots rastreen páginas que contengan información confidencial, como áreas de administración, formularios de registro o datos de usuarios.

- Mejorar el rendimiento del sitio: Al restringir el acceso a páginas no importantes, reduces la carga en tu servidor y mejoras la velocidad de carga de tu sitio web.

- Controlar el rastreo de imágenes y archivos multimedia: Puedes especificar qué imágenes y archivos multimedia se pueden indexar y cuáles no.

- Evitar el rastreo de páginas duplicadas: Puedes evitar que los robots rastreen versiones duplicadas de tu sitio web, como páginas con parámetros de URL diferentes.

- Gestionar el rastreo de sitios web dinámicos: Puedes controlar cómo los robots rastrean sitios web que utilizan tecnologías como JavaScript o AJAX.

¿Cómo se crea un archivo Robots.txt?

Para crear un archivo Robots.txt, debes seguir estos pasos:

- Crea un archivo de texto plano con el nombre robots.txt.

- Agrega las instrucciones para los robots en el archivo, utilizando el siguiente formato:

- User-agent: Nombre del robot o del motor de búsqueda.

- Disallow: URL o ruta a la que no se debe acceder.

- Allow: URL o ruta a la que sí se debe acceder.

¿Ejemplos de Instrucciones en Robots.txt?

Estos son algunos ejemplos de instrucciones que puedes utilizar en tu archivo Robots.txt:

Sitemap.xml: Crea un Sitemap.xml para Ayudar a Google a Indexar tu Sitio- Permitir el rastreo de todo el sitio web:

- User-agent:

- Disallow:

- Bloquear el rastreo de una carpeta específica:

- User-agent:

- Disallow: /admin/

- Permitir el rastreo de una página específica:

- User-agent:

- Allow: /contacto/

- Bloquear el rastreo de todos los archivos PDF:

- User-agent:

- Disallow: .pdf

- Bloquear el rastreo de todas las imágenes:

- User-agent:

- Disallow: /images/

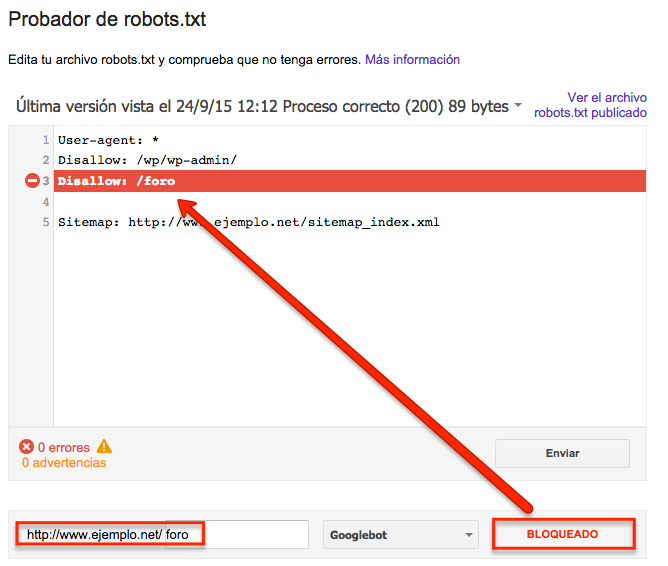

¿Cómo comprobar si tu archivo Robots.txt funciona correctamente?

Puedes comprobar si tu archivo Robots.txt funciona correctamente utilizando las herramientas de Google Search Console. Estas herramientas te permiten ver el contenido de tu archivo Robots.txt y ver qué páginas están siendo bloqueadas por tu archivo.

¿Qué es un archivo bot?

Un archivo bot, en el contexto de la informática, no es un tipo de archivo específico, sino más bien una referencia a cualquier archivo que contenga código diseñado para automatizar tareas o interacciones en un sistema informático. Estos archivos pueden ser ejecutables, scripts o incluso datos, siempre y cuando su contenido esté destinado a ser utilizado por un bot.

Tipos de archivos bot

Los archivos bot pueden tomar diversas formas, dependiendo de su función y el sistema en el que operen:

- Archivos ejecutables: Estos contienen código compilado que se ejecuta directamente en el sistema operativo, como archivos .exe en Windows o .sh en Linux. Pueden ser utilizados para automatizar tareas como descargar archivos, enviar correos electrónicos o interactuar con programas específicos.

- Scripts: Estos archivos contienen código escrito en lenguajes de scripting como Python, JavaScript o PowerShell. Se utilizan para automatizar tareas más simples y flexibles que los archivos ejecutables, y son populares para tareas web o de gestión de sistemas.

- Archivos de configuración: Estos archivos contienen información que define el comportamiento de un bot. Por ejemplo, pueden especificar las acciones a realizar, los datos a utilizar o los comandos a responder.

- Archivos de datos: Estos archivos almacenan datos que el bot necesita para funcionar, como listas de palabras clave, patrones de comportamiento o información sobre los usuarios con los que interactúa.

Ejemplos de archivos bot

- Bots de chat: Los archivos bot que interactúan con usuarios en plataformas de mensajería, como WhatsApp o Telegram. Estos archivos pueden contener código para procesar mensajes, responder preguntas y realizar tareas específicas.

- Bots de redes sociales: Los archivos bot que automatizan tareas en redes sociales como Twitter o Instagram. Estos archivos pueden publicar contenido, seguir usuarios, interactuar con comentarios o analizar datos.

- Bots de comercio electrónico: Los archivos bot que automatizan tareas en sitios web de comercio electrónico, como la gestión de inventario, la realización de pedidos o la atención al cliente.

- Bots de juegos: Los archivos bot que se utilizan para automatizar tareas en videojuegos, como la recolección de recursos, la lucha contra enemigos o la realización de misiones.

Usos de los archivos bot

- Automatización de tareas: Los archivos bot pueden usarse para automatizar tareas repetitivas o complejas, liberando tiempo y esfuerzo humano.

- Interacción con sistemas: Los archivos bot pueden interactuar con sistemas informáticos para realizar tareas o obtener información, como acceder a bases de datos o ejecutar scripts.

- Mejora de la eficiencia: Los archivos bot pueden optimizar procesos y aumentar la eficiencia en diferentes ámbitos, como la atención al cliente, la gestión de redes sociales o la investigación.

- Personalización de experiencias: Los archivos bot pueden personalizarse para ofrecer experiencias únicas a los usuarios, como sugerencias de productos o respuestas personalizadas.

Riesgos de los archivos bot

- Malware: Algunos archivos bot pueden ser utilizados para difundir malware o realizar ataques cibernéticos, por lo que es importante descargar archivos de fuentes confiables.

- Spam: Los archivos bot pueden ser utilizados para enviar spam o realizar actividades no deseadas, lo que puede generar molestias a los usuarios y afectar la reputación de una empresa.

- Violación de la privacidad: Los archivos bot pueden recopilar datos personales de los usuarios sin su consentimiento, lo que puede violar la privacidad y generar problemas legales.

¿Dónde está el archivo robots.txt en WordPress?

El archivo robots.txt en WordPress se encuentra en la raíz de tu sitio web, lo que significa que está en el mismo directorio donde están las carpetas wp-admin y wp-content. Puedes acceder a él a través de tu cliente FTP o mediante el administrador de archivos de tu hosting.

¿Cómo puedo acceder al archivo robots.txt en WordPress?

Para acceder al archivo robots.txt en WordPress, puedes usar diferentes métodos:

- FTP: Conéctate a tu sitio web mediante FTP y busca el archivo robots.txt en la carpeta raíz.

- Administrador de archivos del hosting: Ingresa al panel de control de tu hosting y utiliza su administrador de archivos para localizar el archivo robots.txt en la carpeta raíz.

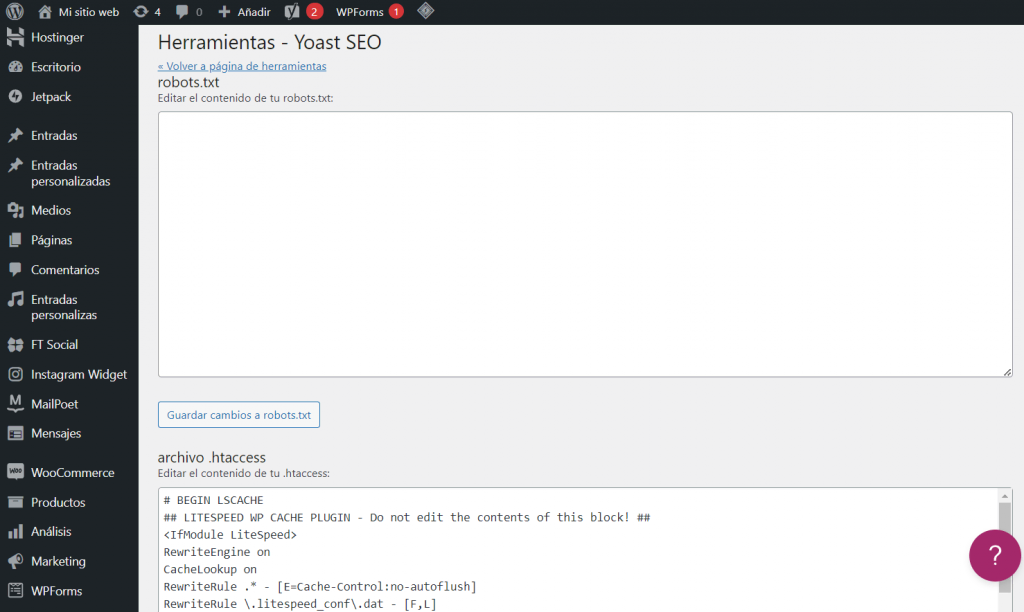

- Plugins: Hay algunos plugins de WordPress que te permiten gestionar el archivo robots.txt, como Yoast SEO, Rank Math SEO o All in One SEO Pack.

¿Por qué es importante el archivo robots.txt?

El archivo robots.txt es un archivo de texto que indica a los robots de los motores de búsqueda qué páginas de tu sitio web pueden o no ser indexadas. Esto te permite controlar qué contenido se muestra en los resultados de búsqueda y qué contenido se mantiene privado.

¿Qué debo incluir en el archivo robots.txt?

En el archivo robots.txt, puedes incluir las siguientes instrucciones:

- User-agent: Especifica el nombre del robot al que se aplica la instrucción.

- Disallow: Indica a los robots que no indexen las páginas o rutas especificadas.

- Allow: Indica a los robots que pueden indexar las páginas o rutas especificadas.

- Sitemap: Proporciona la URL de tu mapa del sitio para que los robots puedan encontrar todas las páginas de tu sitio web.

¿Cómo puedo editar el archivo robots.txt en WordPress?

Puedes editar el archivo robots.txt mediante un editor de texto simple como Notepad o TextEdit. Asegúrate de guardar el archivo como un archivo de texto plano con la extensión .txt.

AMP (Accelerated Mobile Pages): Implementa AMP para Páginas Móviles Más RápidasImportante: Es recomendable que tengas una copia de seguridad del archivo robots.txt antes de editarlo, para evitar errores.

¿Qué es el archivo robots.txt personalizado en Blogger?

El archivo robots.txt personalizado en Blogger es un archivo de texto que se coloca en la raíz de tu blog y que indica a los motores de búsqueda qué páginas o secciones de tu sitio web no deben indexar. Este archivo es un protocolo que permite a los webmasters controlar el acceso de los robots de los motores de búsqueda a determinadas partes de su sitio web.

¿Para qué sirve el archivo robots.txt en Blogger?

El archivo robots.txt sirve para indicar a los robots de los motores de búsqueda qué páginas o secciones de tu blog no deben indexar por diferentes motivos. Algunas razones para bloquear contenido a los robots de búsqueda son:

- Evitar que los robots indexen contenido repetido o duplicado como las páginas de categorías o etiquetas, o las páginas de los comentarios.

- Prevenir que los robots indexen contenido confidencial o privado como las páginas de administración o las páginas de usuarios registrados.

- Asegurarse de que los robots indexen el contenido más importante de tu blog y no las páginas de baja calidad o las páginas que no aportan valor al usuario.

¿Cómo se crea un archivo robots.txt personalizado en Blogger?

Para crear un archivo robots.txt personalizado en Blogger, primero debes acceder al panel de control de tu blog. Después, debes seguir estos pasos:

Guest Posting: Consigue Enlaces de Calidad con Guest Posts- Haz clic en "Configuración".

- Selecciona "Búsqueda y páginas".

- En la sección "Robots.txt", haz clic en "Editar".

- En el editor de texto, ingresa las directivas que quieres que los robots de búsqueda cumplan.

- Guarda los cambios.

Ejemplo de archivo robots.txt personalizado en Blogger

Aquí tienes un ejemplo de un archivo robots.txt que podría ser útil para un blog de Blogger:

User-agent:

Disallow: /search

Disallow: /feed

Disallow: /comments

Disallow: /category/

Disallow: /tag/

Este archivo impedirá que los robots de búsqueda indexen las siguientes páginas:

- La página de búsqueda.

- El feed de RSS.

- La página de comentarios.

- Las páginas de categorías.

- Las páginas de etiquetas.

Recomendaciones para el archivo robots.txt en Blogger

Es importante que el archivo robots.txt sea actualizado y adecuado a las necesidades de tu blog.

- No abuses del archivo robots.txt: Solo bloquea las páginas o secciones que realmente no quieres que sean indexadas.

- Ten en cuenta el impacto en el SEO: Bloquear ciertas páginas puede afectar negativamente al posicionamiento de tu blog en los motores de búsqueda.

- Utiliza herramientas online para validar tu archivo robots.txt: Hay varias herramientas online que te permiten comprobar si tu archivo robots.txt es válido y si está configurado correctamente.

Mas informacion

¿Qué es un archivo robots.txt?

Un archivo robots.txt es un archivo de texto simple que se coloca en la raíz de tu sitio web (por ejemplo, www.tusitio.com/robots.txt) y sirve como una guía para los robots de búsqueda, también conocidos como crawlers o bots, que indexan tu sitio web. Este archivo define qué partes de tu sitio web los bots pueden o no acceder.

Yoast SEO: Plugin SEO para WordPress¿Por qué necesito un archivo robots.txt?

Un archivo robots.txt te permite controlar el acceso de los bots a tu sitio web por varias razones:

- Protege contenido confidencial: Puedes bloquear el acceso a páginas que contienen información sensible, como áreas de administración, datos personales o contenido que no deseas que se indexe.

- Controla el rastreo de tu sitio web: Puedes indicar a los bots que se concentren en las páginas más importantes de tu sitio web, evitando que rastreen áreas innecesarias o que consumen muchos recursos.

- Mejora la velocidad de carga de tu sitio web: Al bloquear el acceso a áreas irrelevantes, reduces la carga en tu servidor y mejoras la velocidad de carga de tu sitio web.

- Evita problemas de duplicación de contenido: Puedes evitar que los bots indexen contenido duplicado o similar, como versiones de impresión de tu contenido web.

¿Cómo puedo crear un archivo robots.txt?

Crear un archivo robots.txt es simple:

- Crea un archivo de texto plano llamado "robots.txt".

- Agrega las reglas que quieres aplicar.

- Guarda el archivo en la raíz de tu sitio web.

Las reglas en el archivo robots.txt se escriben usando una sintaxis específica. Por ejemplo, la siguiente regla bloquea a todos los bots de acceder a la carpeta "admin":

User-agent: Disallow: /admin/

¿Qué debo incluir en mi archivo robots.txt?

La información que incluyas en tu archivo robots.txt dependerá de tus necesidades y objetivos. Algunas recomendaciones incluyen:

- Bloquear archivos innecesarios: Como archivos de configuración, copias de seguridad o archivos temporales.

- Bloquear contenido confidencial: Como áreas de administración, formularios de contacto o páginas con información sensible.

- Definir las páginas prioritarias: Indicando a los bots qué páginas son más importantes para tu sitio web.

- Evitar contenido duplicado: Bloqueando versiones de impresión de tu contenido o archivos de traducción que no quieres que se indexen.

Recuerda que el archivo robots.txt es una herramienta importante para controlar el acceso de los bots a tu sitio web, y es crucial que lo configures correctamente para que funcione según lo previsto.

Google Analytics: Analiza el Tráfico de tu Sitio WebSi quieres conocer otros artículos parecidos a Robots.txt: Crea un Archivo Robots.txt para Controlar el Acceso de los Bots puedes visitar la categoría SEO.

Deja una respuesta

Entradas relacionadas